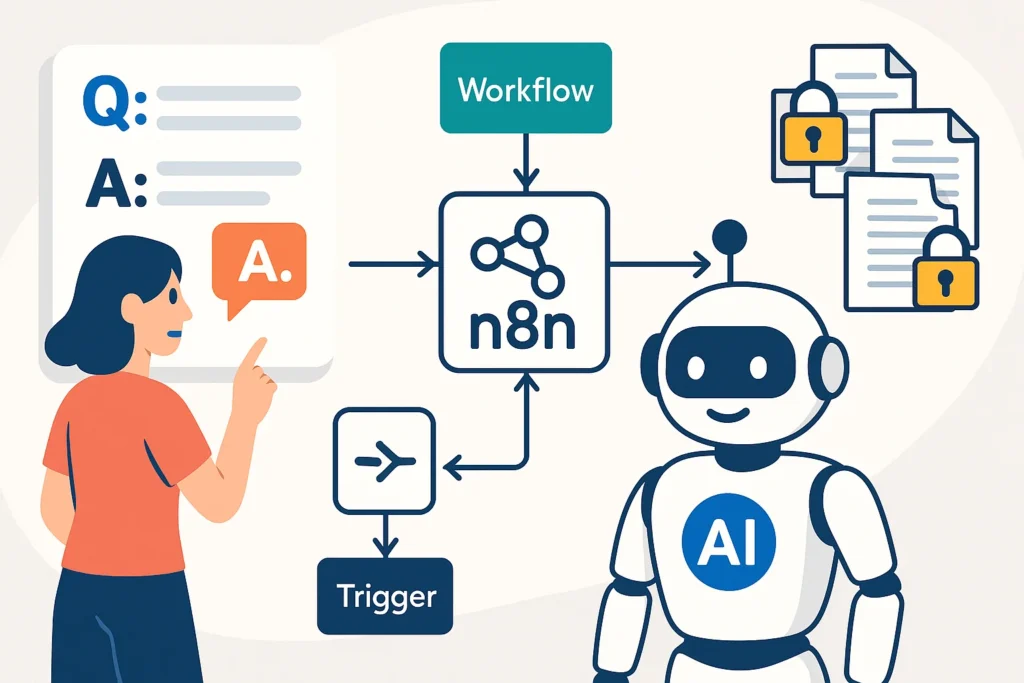

你是否曾夢想過,能擁有一個專屬於你個人或公司的 AI 助理?一個不只能夠上知天文、下知地理,更能熟讀你內部所有文件——從產品規格書、會議紀錄、法律合約,到個人筆記——並根據這些「私有知識」提供精準回答的 AI 大腦。

這,就是 RAG (Retrieval-Augmented Generation,檢索增強生成) 技術的魔力。它讓大型語言模型 (LLM) 不再只依賴其龐大的通用訓練數據,而是能像一位開卷考的學霸,在回答問題前,先「檢索」你提供的特定文件,然後再根據這些文件內容,「生成」最貼切、最準確的答案。

過去,要打造這樣的系統,往往是程式高手的專利。但現在,透過 n8n 這個強大的視覺化自動化平台,你完全可以在不寫或只寫極少量程式碼的情況下,親手建立起一個功能完整的私有文件 AI 問答系統。

這篇文章將是你的 n8n RAG 終極實戰指南。我們將從 RAG 的核心概念講起,一步步拆解流程,並手把手帶你使用 n8n 的核心節點,打造一個能夠讀取你指定文件、並回答相關問題的自動化工作流。

什麼是 RAG?解構 AI 的「開卷考」三部曲

在我們動手之前,必須先理解 RAG 的運作原理。你可以把它想像成一個三步驟的智慧流程,這也是 AI 能夠回答私有知識的核心秘密。

- 建立索引 (Indexing – 存入知識):

- 讀取與切割 (Load & Chunk): 首先,系統會讀取你提供的文件(PDF, TXT, DOCX 等),並將其切割成數個有意義的小段落或「知識碎片」。

- 向量化 (Embedding): 接著,透過一個特殊的 AI 模型(Embedding Model),將這些文字碎片轉換成一長串數字,也就是「向量 (Vector)」。這些向量代表了文字在語義空間中的位置。

- 存入向量資料庫 (Vector Store): 最後,將這些向量與其對應的原文碎片,一同存入一個專門的「向量資料庫」中。這個過程,就好像為你的所有文件,建立了一套超高效的語義索引。

- 檢索 (Retrieval – 查找相關資料):

- 當你提出一個問題時(例如:「我們的退貨期限是幾天?」),系統會先將你的「問題」也轉換成一個向量。

- 接著,系統會拿著這個問題向量,去向量資料庫中進行「相似度搜索」,找出與你的問題在語義上最接近的幾個知識碎片(例如,文件中關於「七天鑑賞期」和「退貨流程」的段落)。

- 生成 (Generation – 綜合回答):

- 這是最關鍵的一步。系統並不會直接把找到的碎片丟給你,而是會將你的「原始問題」和「檢索到的相關知識碎片」,一同打包成一個新的提示 (Prompt)。

- 最後,將這個包含上下文的完整 Prompt,發送給一個強大的大型語言模型(如 GPT-5 或 Llama 3),並下達指令:「請根據我提供的『上下文資料』,回答這個『問題』。」

- LLM 會像開卷考一樣,只根據你提供的資料來生成答案,從而確保了回答的準確性與事實依據。

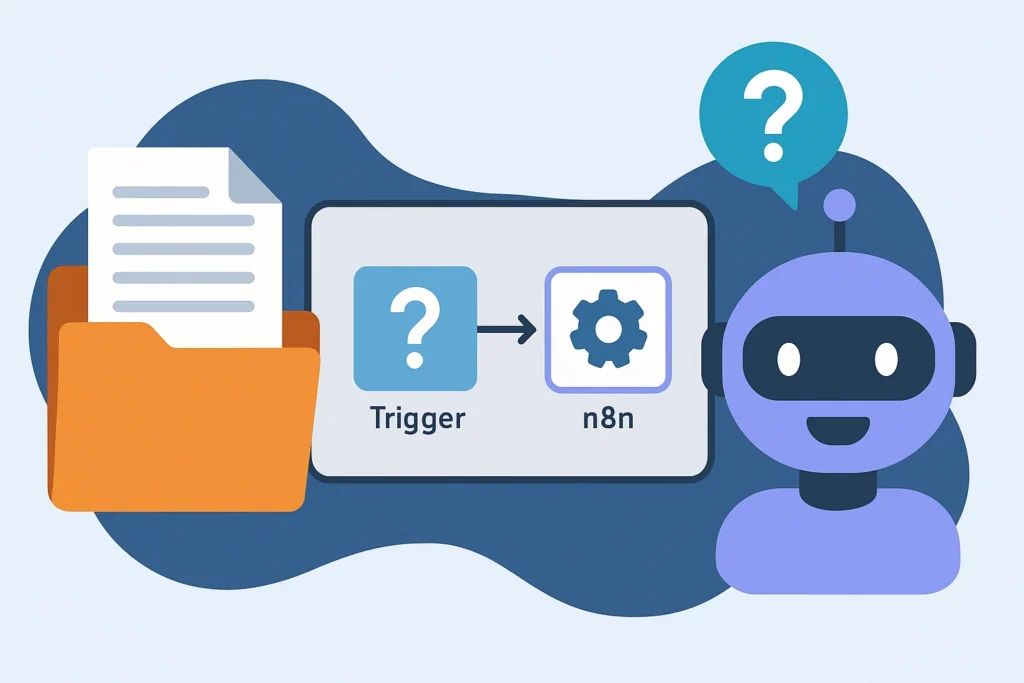

步驟一:準備你的知識庫 — 從文件載入到向量化索引

這是打造 RAG 應用的第一階段:將你的私有文件轉換成 AI 可以理解和檢索的知識庫。我們需要建立一個一次性的「索引工作流 (Indexing Workflow)」。

流程設計: Start -> Read Binary File -> Text Splitter -> Vector Store

- 文件載入 (Loading):

- 使用

Read Binary File節點來讀取你存放在本地的.txt,.pdf或.md文件。如果你文件存放在雲端,也可以使用Google Drive或Notion等節點作為起點。

- 使用

- 文本切割 (Chunking):

- 將文件讀取節點的輸出,連接到

Text Splitter節點。大型語言模型有其處理長度的限制,直接將整份幾萬字的文件丟給它,效果通常不佳。此節點能將長文智能地切割成較小的、保有完整語意的段落,方便後續的檢索。

- 將文件讀取節點的輸出,連接到

- 向量化與儲存 (Embedding & Storing):

- 新增

Vector Store節點(或其他向量資料庫節點如Chroma,Pinecone)。 - Operation: 選擇

Upsert(新增或更新)。 - Collection Name: 為你的知識庫取一個獨一無二的名稱,例如

company_faq。 - Embedding Model: 選擇一個 Embedding AI 模型,例如

OpenAI。你需要在此設定你的 OpenAI API Key 憑證。這個模型負責將文字碎片轉換成向量。 - 將

Text Splitter的輸出連接到Vector Store節點。

- 新增

執行這個工作流後,你的文件就已經被轉化為 AI 的長期記憶,靜靜地存放在向量資料庫中,等待被喚醒。

步驟二:建立問答流程 — 讓 n8n 成為 AI 的溝通橋樑

知識庫準備好了,接下來我們要建立第二個「問答工作流 (Q&A Workflow)」,這才是使用者會直接互動的流程。

流程設計: Webhook -> Vector Store -> Set (Prompt Engineering)

- 接收問題 (Trigger):

- 使用

Webhook節點作為起點。它會產生一個專屬 URL,你可以將它對接到你的網站聊天室、LINE Bot 或任何前端應用,用來接收使用者傳來的問題。

- 使用

- 檢索相關知識 (Retrieval):

- 連接一個與上一步相同的

Vector Store節點。 - Operation: 這次改為選擇

Similarity Search(相似度搜索)。 - Collection Name: 輸入完全相同的知識庫名稱

company_faq。 - Query (使用 Expression):

{{ $json.query.question }}。這段語法會從 Webhook 的 URL 參數中,動態地抓取使用者提出的問題。 - 這個節點會根據問題,從你的知識庫中找出最相關的幾段文字,並將它們輸出。

- 連接一個與上一步相同的

- 建構提示詞 (Prompt Engineering):

- 這是 RAG 的靈魂所在!新增一個

Set節點來組合最終要給 LLM 的「考卷」。 - 新增一個名為

prompt的欄位,並在 Value 中貼上以下的「提示詞模板」:請根據以下提供的「上下文資料」,用繁體中文簡潔地回答「使用者的問題」。請只使用上下文資料中的資訊來回答,如果資料不足以回答,請直接說「根據我目前的知識,我無法回答這個問題」。 --- 上下文資料: {{ $input.all().map(item => item.json.pageContent).join('\n---\n') }} --- 使用者的問題: {{ $node["Webhook"].json.query.question }}

- 這是 RAG 的靈魂所在!新增一個

這個 Set 節點的輸出,就是一份包含了背景資料和使用者問題的、結構清晰的完整提示詞。

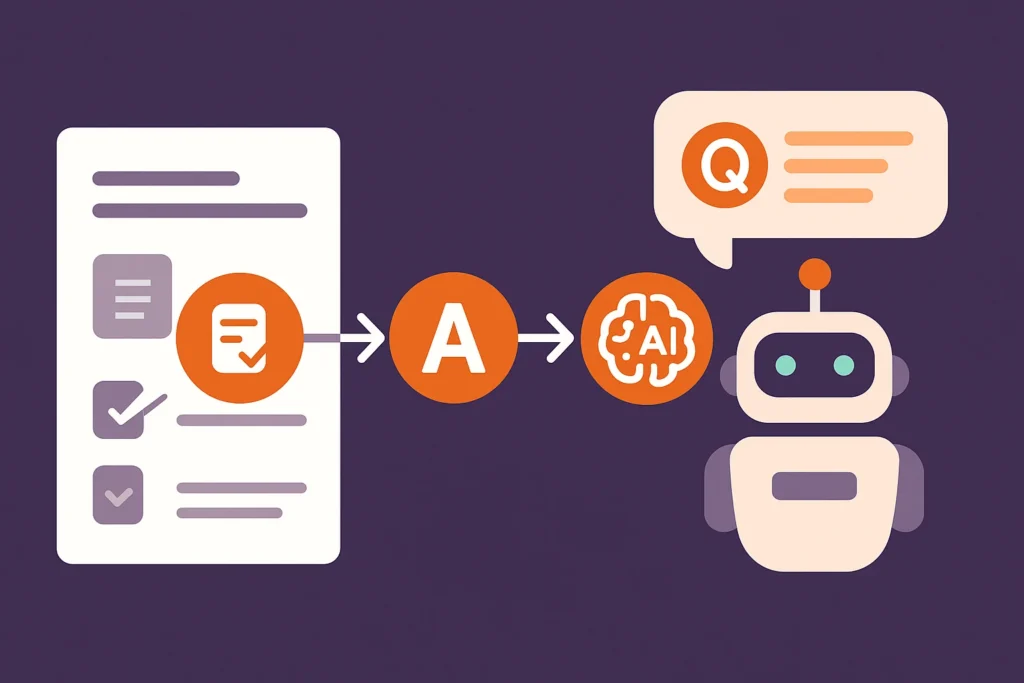

步驟三:串接大型語言模型 (LLM) — 生成最終答案

有了包含上下文的精準 Prompt,最後一步就是將它交給真正的大腦——大型語言模型——來生成最終的回答。

流程設計: (承接上一步) -> OpenAI / Ollama

- 選擇你的 AI 大腦:

- 雲端方案 (推薦入門): 新增

OpenAI節點,選擇gpt-5或gpt-4o等強大模型,效果最好、設定最簡單。 - 本地化方案 (注重隱私/免費): 新增

Ollama節點,連接到你本地運行的Llama 3等開源模型,確保資料 100% 不外洩。

- 雲端方案 (推薦入門): 新增

- 設定 LLM 節點:

- Resource/Operation: 選擇

Chat Completion(聊天模式)。 - Messages > User > Content (使用 Expression):

{{ $json.prompt }}。將我們在上一步Set節點精心組合好的完整提示詞,傳遞給 AI。

- Resource/Operation: 選擇

現在,啟用這個問答工作流。當你透過 Webhook URL 提出一個關於你文件內容的問題時(例如 .../webhook?question=退貨運費由誰負擔),這個流程的最終輸出,就會是 AI 深入理解你的文件後,所生成的精準答案!

RAG 系統架構總覽與進階優化技巧

一個完整的 n8n RAG 系統,由兩個核心工作流組成:

- 索引流 (一次性/定期執行):

文件來源->切割->存入向量資料庫 - 問答流 (即時觸發):

使用者問題->檢索向量資料庫->組合 Prompt->LLM 生成答案

如何讓你的 RAG 系統更強大?

- 優化文件切割 (Chunking):

Text Splitter節點中的Chunk Size和Chunk Overlap是影響檢索品質的關鍵參數。你需要根據文件的結構進行實驗,找到最適合的切割大小。 - 處理「查無資料」的情境: 你可以在

Vector Store (Similarity Search)節點後加上一個IF節點,判斷它是否有回傳任何結果。如果沒有,就直接回覆使用者「抱歉,找不到相關資訊」,而不需要再浪費 Token 去問 LLM。 - 定期更新索引: 如果你的知識庫文件會頻繁變動,你可以將「索引工作流」的觸發器從手動改為

Schedule節點,讓它每天或每週自動重新建立索引,確保 AI 的知識永遠保持在最新狀態。

結語

n8n 已經將過去需要由專業 AI 工程師才能完成的 RAG 系統開發,徹底地「民主化」與「視覺化」。透過拖拉組合幾個核心節點,你就為你的 n8n 自動化系統,裝上了一個能夠學習私有知識、並依此進行精準問答的客製化 AI 大腦。

這個技術的應用潛力是無窮的:

- 企業內部: 建立一個能回答新人所有 HR 問題的 AI、一個能讓工程師快速查詢技術文件的 AI。

- 客戶服務: 打造一個 24 小時不休息的 AI 客服,處理 80% 的常見問題,讓人力專注在更複雜的案例上。

- 個人知識管理: 將你所有的讀書筆記、想法、會議紀錄全部餵給 AI,讓它成為你最強大的第二大腦。

從今天起,就動手將你那些沉睡在硬碟深處的文件與知識,透過 n8n 賦予它們與你對話的能力吧!

更多精選文章請參考

n8n 與 Zapier 比較:該選哪個?2025年最完整功能、費用、優缺點分析

開源自動化工具推薦:從工作流程到測試,找到最適合你的免費方案

n8n 發送 Email 超詳細教學:從 SMTP 設定到 Gmail 節點串接,一篇搞定!

n8n Notion 串接終極指南:2025 年打造自動化工作流程,效率翻倍!